- Warum wir?

- Warum Sie TWIPLA verwenden sollten

- Warum von Google Analytics wechseln?

- Fünf von TWIPLA gelöste Webanalyse-Probleme

- Cookieless-Tracking

- Maximum Privacy Modus

- Duale Tracking-Code-Optionen für optimiertes Besucher-Tracking

- Einrichtung des First-Party-Tracking

- Partnerprogramm

- Kostenfreie Produkt-Demo buchen

- Funktionen

White Label

Für SaaS-Anbieter & Agenturen

Stellen Sie Ihren Kunden unsere komplette Analytics-Suite zur Verfügung, direkt in Ihrer eigenen Benutzeroberfläche und mit Ihrem eigenen Branding. Entdecken Sie Analytics-as-a-Service und White Label Analytics. Großer Nutzen, minimaler Aufwand.

- Preise

- White Label

- Erfolgsgeschichten

- Partner

- RessourcenWissensdatenbank

- Kleine Unternehmen

- Digital-Vermarkter

- Webseiten-Analysten

- Unternehmen, Agenturen und SaaS

- Webseiten-Statistiken

- Verhaltensanalyse

- Besucherkommunikation

- DSGVO & Datenschutzgesetze

- Webseiten-Intelligenz

- Digital-Marketing

- Produkt-Aktualisierungen

- Unternehmens-Neuigkeiten

- Newsletter

- Leitfäden

- E-Commerce

INHALT

- Überblick: Was ist ChatGPT?

- Der Zweck von ChatGPT

- Unzulänglichkeiten von ChatGPT

- ChatGPT und Datenschutz: Der Rahmen der Frage

- Konflikt zwischen GDPR und künstlicher Intelligenz

- ChatGPTs Praktiken der Datenerfassung

- ChatGPT und GDPR-Konformität

- Warum ChatGPT die GDPR-Anforderungen nicht erfüllt

- OpenAIs Datenpanne

- ChatGPT und Datenschutz: Probleme in Italien

- OpenAIs weitere Themen in der EU

- Tiefer gehende Bedenken über AI-Chat-Tools

- ChatGPTs Antwort auf Datenschutzbedenken

- Datenschutzorientierte Technologie: die Zukunft für datensichere generative KI

- Aufkommende Datenschutz-Innovationen

- FAQs

- Was ist ChatGPT?

- Sammelt ChatGPT persönliche Daten?

- Ist ChatGPT GDPR-konform?

- Sind die Daten in ChatGPT sicher?

ChatGPT und Datenschutz: Ist das OpenAI-Tool sicher?

Die enge Verbindung zwischen ChatGPT und Datenschutz ist für jeden, der sich dafür interessiert, ziemlich offensichtlich.

Das OpenAI-Sprachwerkzeug ist im letzten Jahr explosionsartig ins öffentliche Bewusstsein gerückt. Es erfreut sich inzwischen großer Beliebtheit, und zwar nicht nur bei Studenten, die mit einer Aufgabe im Verzug sind.

Heute nutzen es viele Unternehmen, um Fragen zu beantworten, effektive Marketingstrategien zu entwickeln und alle Arten von Kurz- und Langform-Inhalten zu erstellen. Der KI-Chat revolutioniert auch die Technologiebranche und wird daher zweifellos eine Schlüsselrolle für die Zukunft des digitalen Marketings spielen.

Aber was passiert mit den eingegebenen Daten, und ist ChatGPT GDPR-konform?

Dieser Artikel befasst sich mit dem faszinierenden Spielzeug von OpenAI. Er untersucht die Beziehung zwischen ChatGPT, GDPR und Datenschutz und beleuchtet die verschiedenen Aspekte, die dabei eine Rolle spielen.

Treten wir in den Chat ein!

Überblick: Was ist ChatGPT?

ChatGPT ist ein KI-gestütztes Gesprächsmodell, das von OpenAI entwickelt wurde.

Es gehört zur GPT-Familie (Generative Pre-trained Transformer). Diese Technologie nutzt fortschrittliche Techniken des Deep Learning, um Text zu erzeugen, der der menschlichen Sprache sehr ähnlich ist.

Die Neuigkeiten über die Fähigkeiten von ChatGPT-4 verbreiteten sich schnell. Innerhalb weniger Tage nach dem Start haben sich mehr als eine Million Nutzer auf der Plattform registriert.

Damit ist es das erste KI-gestützte Sprachtool, das von der Öffentlichkeit in so großem Umfang genutzt wird. Derzeit hält es den Rekord als die am schnellsten wachsende Verbraucheranwendung der Geschichte.

Dies ist definitiv ein Zeichen für die Zukunft und ein weiterer Beweis dafür, wie KI die Zukunft des digitalen Marketings und darüber hinaus verändern wird.

Der Zweck von ChatGPT

Der Schwerpunkt von ChatGPT liegt auf der Generierung von Konversationsantworten, was es ideal für interaktive Anwendungen, Chatbot-Systeme und Conversational Marketing macht. Es wurde auf eine Vielzahl von Internettexten trainiert, was ihm hilft, eine breite Palette von Themen und Fragen zu verstehen und zu beantworten.

Eine bemerkenswerte Eigenschaft von ChatGPT ist seine Fähigkeit, kontextrelevante und kohärente Texte zu produzieren und so Konversationserlebnisse zu schaffen, die einer menschlichen Interaktion ähneln.

Für Unternehmen kann es für alles verwendet werden, vom E-Mail-Marketing bis zum Social Media Marketing und sogar für die Entwicklung umfassenderer Marketingstrategien.

Man darf jedoch nicht vergessen, dass ChatGPT auf Mustern beruht, die aus Trainingsdaten gelernt wurden, und kein echtes Verständnis oder Bewusstsein besitzt.

OpenAI hat verschiedene Versionen des GPT-Modells veröffentlicht, wobei jede Iteration darauf abzielt, die Einschränkungen der Vorgänger zu verbessern. Die Benutzer können ChatGPT-4 vorerst ausprobieren. Da OpenAI jedoch noch nicht mit dem Training für die nächste Version begonnen hat, wird es noch lange dauern, bis wir ChatGPT-5 sehen werden.

Unzulänglichkeiten von ChatGPT

Die verschiedenen Generationen haben ein beeindruckendes Wachstum der Sprachfähigkeiten gezeigt. Sie geben jedoch auch Anlass zur Sorge über ungenaue Informationsgenerierung, verwirrende Urheberrechtsfragen und fragwürdige Datenschutzpraktiken - dazu später mehr.

Letztendlich ist ChatGPT weit davon entfernt, einen guten Schriftsteller zu ersetzen. Und während viele Unternehmen versuchen, Hunderte von KI-generierten Artikeln zu veröffentlichen, um das System zu manipulieren und die Suchmaschinenoptimierung nach oben zu treiben, scheint diese Strategie nur von kurzer Dauer zu sein, da Googles Web-Crawler diese Taktik bald durchschauen und anstößige Seiten entsprechend abstrafen wird.

ChatGPT und Datenschutz: Der Rahmen der Frage

Um die Beziehung zwischen ChatGPT und dem Datenschutz zu verstehen, müssen wir das Zusammenspiel zwischen den Interaktionen der Nutzer und der Verarbeitung der von ihnen bereitgestellten Informationen untersuchen.

Wenn wir uns mit ChatGPT unterhalten, geben wir bereitwillig Einblicke in unser Leben und unsere persönlichen Erfahrungen.

Doch was passiert mit diesen Daten, sobald sie unsere Tastaturen verlassen? Sind sie sicher geschützt, oder werden sie zu einer handelbaren Ware, die ohne unsere ausdrückliche Zustimmung ausgebeutet werden kann? Dies wirft eine ganze Reihe moralischer und rechtlicher Fragen auf, aber wir wollen uns hier auf die rechtlichen Fragen beschränken.

Konflikt zwischen GDPR und künstlicher Intelligenz

Die Wahrung des Datenschutzes erfordert oft einen Ausgleich zwischen konkurrierenden Interessen.

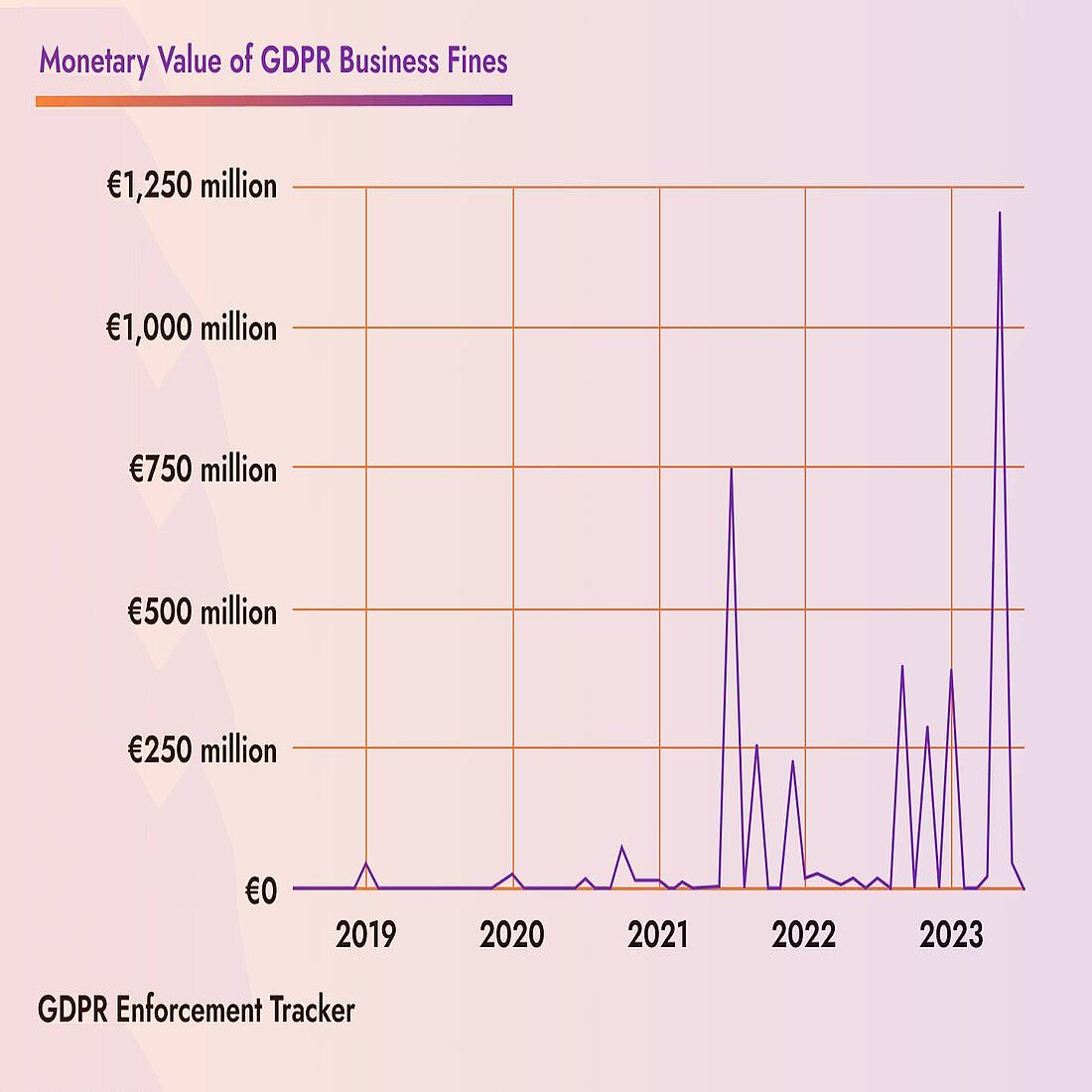

Auf der einen Seite steht die Datenschutz-Grundverordnung (GDPR), ein solider rechtlicher Rahmen, der die Datenschutzrechte der EU-Bürger schützen soll. Es handelt sich um eine strenge Gesetzgebung zum Schutz personenbezogener Daten, und die GDPR hat reale Auswirkungen auf Vermarkter.

Andererseits hat die KI einen unersättlichen Appetit auf riesige Datenmengen und überschreitet bei ihrer Suche gelegentlich Grenzen.

Sie nutzt Technologien zur Verarbeitung natürlicher Sprache (NLP) und zum maschinellen Lernen, über die Sie in unserem Digital Futures Resource Hub mehr erfahren können. Diese Innovationen stellen eine echte Herausforderung für die Datenschutz-Grundverordnung und andere Datenschutzgesetze dar, die derzeit nicht in der Lage sind, solche Technologien zu regulieren.

Und im weiteren Sinne stellt KI ein echtes Risiko für personenbezogene Daten dar.

Ein Gleichgewicht zwischen diesen gegensätzlichen Kräften herzustellen, ist eine große Herausforderung für OpenAI.

ChatGPTs Praktiken der Datenerfassung

Gemäß der Datenschutzrichtlinie von OpenAI sammelt ChatGPT die folgenden Informationen:

- Kontoinformationen, die eingegeben werden, wenn Nutzer sich anmelden oder für ein Premium-Abo bezahlen

- Informationen, die die Nutzer in den Chatbot selbst eingeben

- Identifizierungsdaten von Benutzergeräten und Browsern

Das bedeutet, dass OpenAI persönliche Daten von Nutzern sammelt und eine große Menge davon auf seinen Servern speichert. OpenAI verwendet die Informationen dann, um das System zu verbessern, und KI-Trainer können sie sogar überprüfen, um die Einhaltung der Vorschriften sicherzustellen.

Es bleibt unklar, wie viele persönliche Daten von ChatGPT verwendet werden. Es liegt jedoch auf der Hand, dass für das Training dieses KI-Sprachwerkzeugs riesige Datenmengen benötigt werden und dass das Unternehmen aus diesem Grund über die Datenmengen Stillschweigen bewahrt.

OpenAI behauptet, dass alle für das Training verwendeten Daten vollständig anonymisiert werden, um alle identifizierbaren Informationen zu entfernen, aber es ist schwierig, dies mit aller Sicherheit zu überprüfen.

ChatGPT und GDPR-Konformität

Unabhängig davon, was ChatGPT öffentlich über die Sicherheit der Nutzerdaten sagt, gibt es einfach zu viele Fragen, um zu sagen, dass ChatGPT GDPR-konform ist.

Zugegeben, die Aufbewahrung von Daten ist für kostenlose und kostenpflichtige Nutzer unterschiedlich - was bedeutet, dass Sie so oder so für den Datenschutz bezahlen. Bezahlte Nutzer kommen in den Genuss zusätzlicher Vorteile, wie die Verwaltung und auch das Löschen persönlicher Daten, was für die Einhaltung der GDPR entscheidend ist.

Dies ist jedoch leichter gesagt als getan.

Warum ChatGPT die GDPR-Anforderungen nicht erfüllt

Nachdem die Nutzer Daten in ChatGPT eingegeben haben, bezieht die Technologie diese Daten vollständig in den Algorithmus ein, was für das Unternehmen eine Herausforderung darstellt, wenn personenbezogene Daten entfernt werden müssen. Folglich wird es für OpenAI immer schwieriger, die Datenschutzanforderungen zu erfüllen.

Auch die Praktiken der physischen Datenspeicherung stellen ein Problem für die GDPR dar. ChatGPT operiert von den USA aus und nutzt Server in einem Microsoft Azure-Rechenzentrum in Texas.

Der Standort der ChatGPT-Server in den USA, wo sie die EU-Standards für den Schutz der Nutzerdaten nicht erfüllen, verstößt gegen die GDPR-Anforderungen für Datenübertragungen außerhalb der EU. Dies ist ein Bereich, der die Hauptlast der GDPR-Durchsetzungsmaßnahmen zu tragen hat, wobei sich die rechtlichen Probleme von Google auf seine eigenen Datenübermittlungen zwischen der EU und den USA sowie auf die Schrems-II-Entscheidung konzentrieren.

In Anbetracht all dessen kann man mit Fug und Recht behaupten, dass ChatGPT die GDPR nicht einhält und nicht in der Lage wäre, die Compliance-Checkliste in unserem Marketer's Guide to GDPR and Data Privacy zu erfüllen.

Die Datenpraktiken sind nicht annähernd transparent genug, und es ist sehr wahrscheinlich, dass die Plattform skrupellos mit den persönlichen Daten der Nutzer umgeht. Die Nutzer werden es auch schwer haben, ihre Rechte gemäß der DSGVO wahrzunehmen - einschließlich ihres Rechts auf Information und des Rechts auf Vergessenwerden.

OpenAIs Datenpanne

OpenAI ist bereits seit sieben Jahren mit dem Problem der Regulierung konfrontiert, und nun hat eine große Datenpanne weitere Schwachstellen im Sicherheitssystem von ChatGPT aufgedeckt.

Dies hat dem Unternehmen noch mehr schlechte Presse eingebracht, und es hat weitere Konsequenzen von Datenaufsichtsbehörden erlitten.

Die Sicherheitsverletzung ereignete sich während eines neunstündigen Zeitfensters am 20. März 2023 - zwischen 10:00 und 19:00 Uhr mitteleuropäischer Zeit (MEZ).

Nach Angaben von OpenAI waren die Daten von etwa 1,2 % der ChatGPT Plus-Abonnenten betroffen. Dies bedeutet, dass bis zu 1,2 Millionen Nutzer potenziell betroffen waren.

Ein Fehler im Quellcode von ChatGPT verursachte die Sicherheitslücke, die zum Verlust sensibler Nutzerdaten führte.

Trotz der sofortigen und wirksamen Gegenmaßnahmen von OpenAI, wie z. B. die Behebung der Sicherheitslücke und die Beruhigung der Nutzer, hat der Vorfall zweifellos das Vertrauen in das KI-System erheblich erschüttert.

ChatGPT und Datenschutz: Probleme in Italien

Die Datenpanne bei ChatGPT hat sicherlich die Aufmerksamkeit auf Datenschutzbedenken gelenkt.

OpenAI war jedoch bereits auf dem Radar der Datenschutzbehörden. Es hatte ein schwieriges Jahr 2023, in dem es in einen Strudel von Kontroversen im Zusammenhang mit der GDPR verwickelt war.

Dabei ging es vor allem um Fragen zur Ethik und Transparenz der Datenerhebungspraktiken von OpenAI. Dazu gehörten auch Vorwürfe, dass OpenAI personenbezogene Daten ohne Genehmigung verwendet hat, was in der gesamten EU für Aufregung sorgte.

Italien war das erste EU-Land, das Maßnahmen gegen OpenAI ergriffen hat - obwohl das Unternehmen in einer Reihe von Ländern verboten ist (siehe Karte unten).

Am 21. März - nicht lange nach dem Datenschutzverstoß - erließ die italienische Datenschutzbehörde (GPDP) eine vorläufige Eilentscheidung. Darin wurde das Unternehmen angewiesen, die Verwendung der personenbezogenen Daten von Millionen von Italienern in seinen Trainingsprotokollen einzustellen.

Garante - die italienische Datenschutzbehörde - argumentierte, dass OpenAI nicht die rechtliche Befugnis habe, diese persönlichen Daten zu nutzen.

Auch die Tendenz von ChatGPT, falsche Informationen zu generieren, wurde als Problem angeführt. Die GDPR-Vorschriften besagen, dass alle personenbezogenen Daten korrekt sein müssen, was in der Pressemitteilung von Garante hervorgehoben wurde.

Die Agentur warf dem Unternehmen auch vor, die Anforderungen zur Altersverifizierung zu ignorieren und damit Minderjährige zu gefährden, und zwang OpenAI, den italienischen Zugang zu seinem Chatbot zu beschränken.

OpenAIs weitere Themen in der EU

Die regulatorischen Probleme von ChatGPT in Italien sind erst der Anfang.

Konkurrenten wie Googles Bard und Azure AI (das ebenfalls auf OpenAI basiert) werden ihre Entwicklung aufmerksam verfolgen.

Seit März haben mindestens drei EU-Länder - Deutschland, Frankreich und auch Spanien - damit begonnen, gegen ChatGPT zu ermitteln. Das Vereinigte Königreich tut dasselbe, und der Europäische Datenschutzausschuss (EDPB) hat eine Task Force eingerichtet, um diese verschiedenen Untersuchungen zu koordinieren.

Und da es sich um das strengste und einflussreichste Datenschutzgesetz der Welt handelt, wird die Anwendung der GDPR-Grundsätze auf OpenAI seismische Folgen haben, die weit über Europa hinausreichen werden.

Aber auch Nicht-EU-Länder zeigen Interesse. So prüft Kanada die Datenschutzpraktiken von OpenAI auf der Grundlage seines Personal Data Protection and Electronics Documents Act (PIPEDA).

Tiefer gehende Bedenken über AI-Chat-Tools

Es gibt echte Bedenken darüber, wie KI-Tools wie ChatGPT Informationen sammeln und generieren.

Dazu gehören die Art und Weise, wie Plattformen Daten in ihren Trainingsdaten verwenden, politische Voreingenommenheit und auch ihre Tendenz, Fehlinformationen zu erzeugen. Diese Bedenken sind zugegebenermaßen nicht neu und spiegeln den allgemeinen Diskurs darüber wider, wie das Internet die Gesellschaft beeinflusst.

Fehlinformationen sind besonders besorgniserregend für Unternehmen, die ChatGPT für die Erstellung von Online-Marketing-Inhalten nutzen. Diese Chat-Tools beziehen einen Großteil ihres Wissens aus dem Internet, und ihre Verbreitung von Fehlinformationen könnte eine geschlossene Rückkopplungsschleife von ungenauen Informationen schaffen.

Die Datenschutz-Grundverordnung kann nur bedingt etwas ausrichten, da sie nicht für den direkten Umgang mit KI konzipiert wurde. Allerdings arbeiten die politischen Entscheidungsträger derzeit an einer Gesetzgebung, die sich direkt mit dieser Technologie befassen wird. Das EU-Gesetz über künstliche Intelligenz (Artificial Intelligence Act, AIA), das bereits 2021 vorgelegt wurde, weist den Weg.

Dies ist ein Zeichen für die Zukunft und deutet darauf hin, dass das goldene Zeitalter der relativ unregulierten KI bald so schnell verschwinden könnte, wie es gekommen ist.

ChatGPTs Antwort auf Datenschutzbedenken

Trotz der Herausforderungen ist die Geschichte rund um ChatGPT und den Datenschutz nicht nur düster und düster.

Inmitten der Widrigkeiten hat das KI-Tool seine Widerstandsfähigkeit bewiesen und Verbesserungen vorgenommen.

Nach der erfolgreichen Behebung der angeblichen Datenschutzprobleme gelang es OpenAI, die Garante DPA dazu zu bringen, das Verbot in Italien aufzuheben.

Das Unternehmen erklärte dazu, dass es italienischen Nutzern ein Tool anbieten würde, mit dem sie ihr Alter bei der Anmeldung verifizieren können. Es erklärte, dass es auch ein neues Formular für EU-Nutzer bereitstellen würde, mit dem sie ihr Widerspruchsrecht gegen die Verwendung personenbezogener Daten zum Trainieren ihrer Modelle ausüben könnten - eine zentrale Anforderung der Datenschutzgrundverordnung.

Diese Entwicklung zeigt das Engagement von OpenAI für Datenschutzstandards.

Allerdings muss OpenAI noch einiges tun. Es hat bis zum 30. September 2023 Zeit, ein robusteres System zu entwickeln, um Minderjährige unter 13 Jahren von ChatGPT fernzuhalten. Das Gleiche gilt für ältere, minderjährige Teenager ohne elterliche Zustimmung. Werden diese Maßnahmen nicht ergriffen, wird ChatGPT erneut in Italien gesperrt - wenn nicht sogar darüber hinaus.

Datenschutzorientierte Technologie: die Zukunft für datensichere generative KI

Datenschutz ist im Zeitalter der KI ein dringendes Anliegen.

Und in der Tat dient ChatGPT als bemerkenswerte Fallstudie, die die Herausforderungen und Chancen in diesem Bereich aufzeigt.

Um eine harmonische Koexistenz zwischen KI-Fortschritten und Datenschutz zu erreichen, ist ein vielseitiger Ansatz erforderlich. Dieser Ansatz muss solide Vorschriften, die Befähigung der Nutzer und einen ständigen Dialog umfassen.

Der technologische Fortschritt wird auch den Datenschutz in der KI-gestützten Zukunft erleichtern. OpenAccessGPT und Elastic entwickeln datenschutzfreundliche Technologien für den KI-Chat bzw. die KI-Suche.

Ihre Innovationen werden sich als umso willkommener erweisen, als Unternehmen in einem sich ständig verschärfenden regulatorischen Umfeld nach Alternativen zu ChatGPT Ausschau halten.

Aufkommende Datenschutz-Innovationen

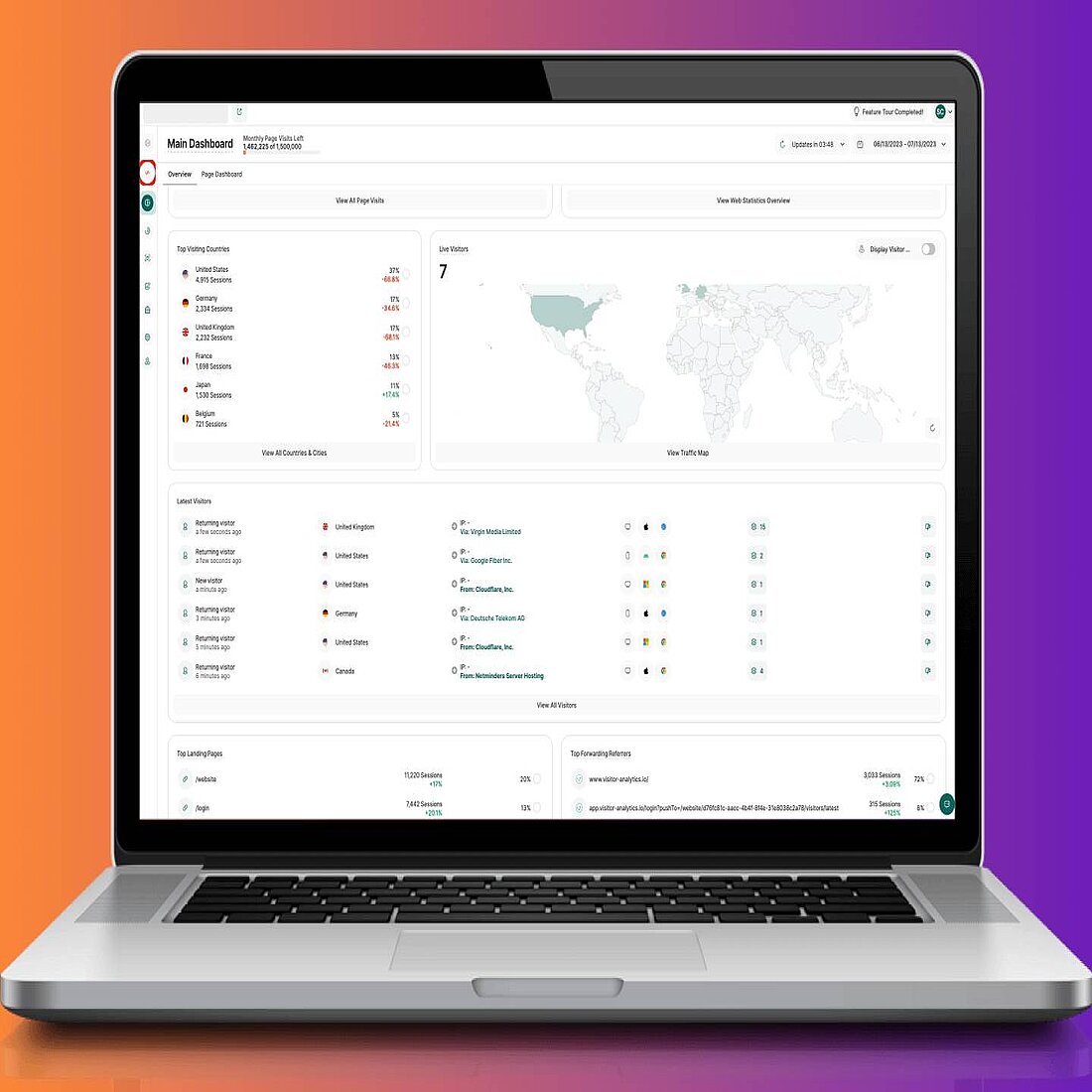

Dies fügt sich in die aktuelle Dynamik der Internettechnologien ein, wo datenschutzflexible Technologien wieTWIPLA entstehen, um digitale Herausforderungen zu meistern.

Unsere Website-Analyseplattform ermöglicht es Unternehmen, Nutzer dank eines fortschrittlichen cookieless-Modells anonym zu verfolgen. Auf diese Weise können sie die Daten sammeln, die sie benötigen, um ihre Website kundenorientiert auszubauen, während die Nutzerdaten gleichzeitig sicher sind.

Datenschutzorientierte Technologie wird auch immer beliebter, da Unternehmen ihre Systeme an den Erwartungen der Kunden in Bezug auf die Datensicherheit ausrichten wollen.

Testen Sie TWIPLA und sehen Sie, was unsere Website-Analyse-Lösung für Ihr Unternehmen tun kann.

Was ist ChatGPT?

ChatGPT ist ein KI-gestütztes Konversationsmodell, das von OpenAI entwickelt wurde. Es gehört zur Familie der GPT-Modelle (Generative Pre-trained Transformer), die fortschrittliche Deep-Learning-Techniken verwenden, um Text zu generieren, der der menschlichen Sprache sehr ähnlich ist. Der Schwerpunkt von ChatGPT liegt auf der Generierung von Konversationsantworten, wodurch es sich für interaktive Anwendungen, Chatbot-Systeme und allgemeines Conversational Marketing eignet. Es wurde mit einer Vielzahl von Internettexten trainiert, so dass es eine breite Palette von Themen und Fragen verstehen und beantworten kann.

Sammelt ChatGPT persönliche Daten?

Ja, ChatGPT sammelt persönliche Daten. Dazu gehören IP-Adressen, Browsertypen und Einstellungen der Nutzer. Es werden auch Daten über die Interaktionen der Benutzer mit der Website gesammelt. Dazu gehören Aufforderungen, die Arten von Inhalten, mit denen sie sich beschäftigen, die verwendeten Funktionen und die von den Nutzern durchgeführten Aktionen.

Ist ChatGPT GDPR-konform?

Nein, ChatGPT ist nicht GDPR-konform. Dies geht aus dem vorübergehenden Verbot des Chatbots durch die italienische Datenschutzbehörde im März 2023 aufgrund von Datenschutzbedenken hervor. Diese Bedenken beziehen sich auf die Verwendung personenbezogener Daten in den Schulungsprotokollen. Außerdem wurde der Chatbot verboten, weil er den Zugang zu Minderjährigen nicht einschränkt - ein Schlüsselelement der GDPR-Konformität. Darüber hinaus speichert er Daten in den USA, lässt Transparenz bei seinen Datenerhebungspraktiken vermissen und es ist unklar, ob Nutzer ihre Daten auf Anfrage löschen können.

Sind die Daten in ChatGPT sicher?

Ja, ChatGPT gilt allgemein als sicher. Die Plattform verwendet Datenverschlüsselung, um alle eingegebenen Daten zu schützen, und sie behaupten, dass der Chatbot über starke Sicherheitsmaßnahmen verfügt. Es besteht jedoch immer das Risiko, dass Daten von Dritten abgefangen oder gehackt werden, und die Datenpanne im März 2023 hat Bedenken hinsichtlich der Datensicherheitsmaßnahmen geweckt.